Индексация лежит в основе продвижения каждого сайта: страница попадает в индекс поисковых систем и начинает конкурировать в выдаче. Чем раньше это случится, тем лучше. Предлагаем 6 советов, как ускорить индексацию сайта, чтобы быстрее оказаться в топе.

Из статьи вы узнаете:

- как настроить инструкции для поисковых роботов в robots.txt;

- как создать и проверить XML Sitemap;

- как оптимизировать скорость загрузки сайта;

- какие факторы влияют на скорость индексации сайта.

Поисковые роботы сами добавляют документы в свою базу данных, поэтому после создания очередной страницы администраторы сайтов просто ждут, когда это произойдет. Однако вы можете ускорить индексацию, чтобы не терять время и как можно скорее начать привлекать пользователей из поисковой выдачи. В этом материале контент-маркетолог Netpeak Software Юля Телижняк рассказала о самых эффективных способах ускорения индексации.

1 Настройте инструкции для поисковых роботов в robots.txt

Директивы в robots.txt указывают ботам поисковых систем, какие страницы следует индексировать, а какие нет. Cо списком всех возможных инструкций вы можете ознакомиться в справке Google.

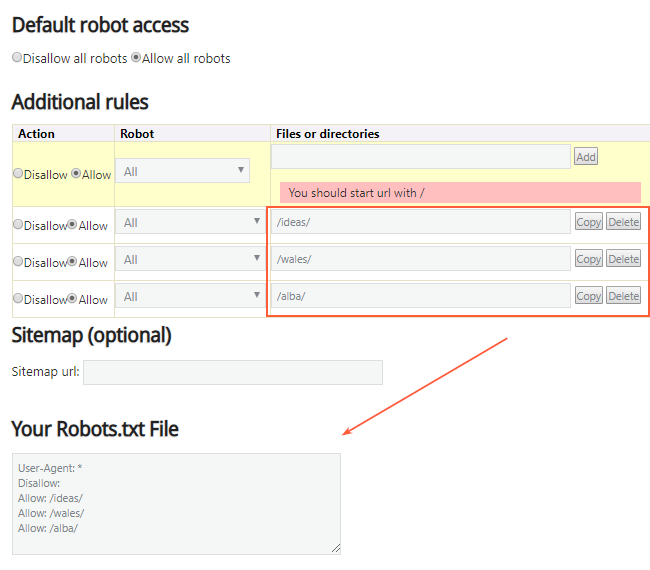

Так как robots.txt представляет собой простой текстовый файл, в большинстве случаев его можно создать и заполнить вручную. Но также этот процесс можно упросить и частично автоматизировать при помощи генератора от SEObook.

Только что созданный файл требует обязательной проверки в панели вебмастеров Google и «Яндекс»: так вы сможете быстро выяснить, нормально ли его распознают и воспринимают поисковые системы.

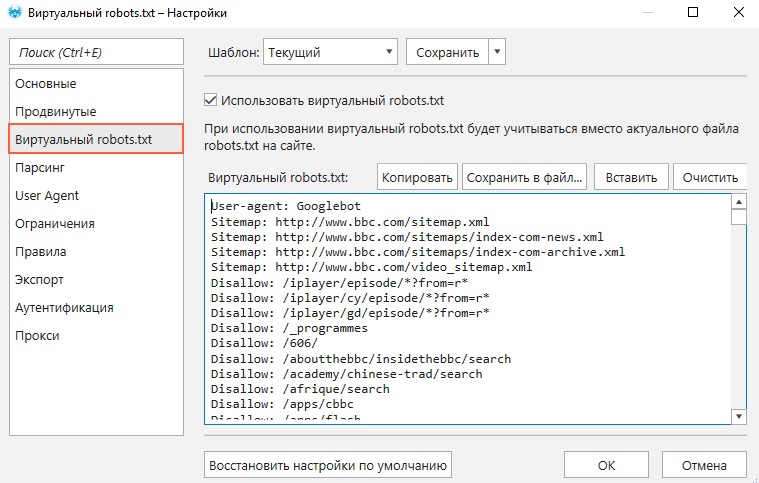

Если перед внедрением нового файла вы хотите узнать, как ваш сайт будет выглядеть в глазах поисковых роботов, воспользуйтесь функцией «Виртуальный robots.txt» в программе Netpeak Spider. Действующий файл при этом менять не нужно.

Чтобы запустить проверку:

- Откройте «Настройки» → «Виртуальный robots.txt». Активируйте функционал и вставьте директивы из файла.

- В основном окне программы впишите в поисковую строку адрес сайта и запустите сканирование.

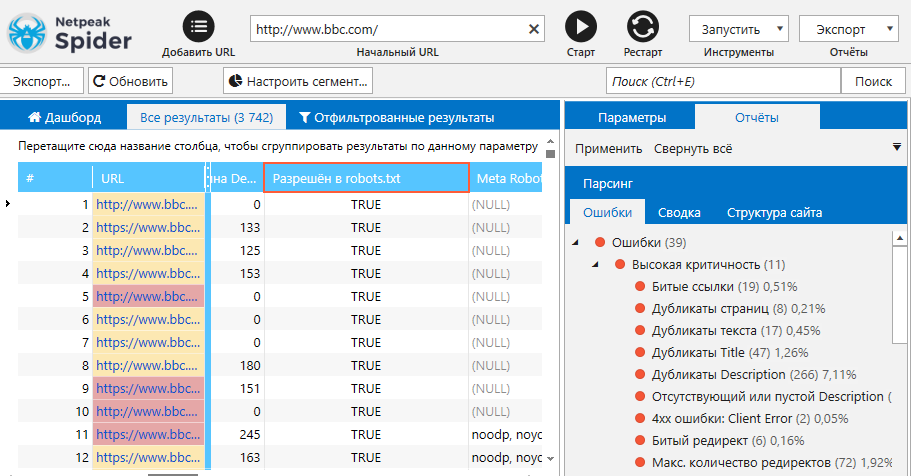

- Значения, актуальные для виртуального robots.txt, отобразятся в колонке «Разрешен в robots.txt».

От правильности настройки директив в robots.txt будет зависеть, какие страницы вашего сайта смогут попасть в индекс.

2 Создайте и систематически проверяйте XML Sitemap

Карта сайта — это файл со списком важных для продвижения страниц сайта. Главная функция XML Sitemap — указать поисковым роботам, по каким страницам им следует пройтись, и какие из них подвергались изменениям за последнее время.

Каждому среднему и большому сайту рекомендуется создать XML Sitemap. Основные требования к картам:

- в одной карте может содержаться не более 49 999 ссылок; если вам необходимо указать большее количество страниц, создайте второй файл XML Sitemap;

- максимальный допустимый размер карты в несжатом виде — 50 МБ;

- домен файла XML Sitemap должен совпадать с доменом сайта, для которого он создается;

- в файле должны содержаться только открытые для индексации файлы и страницы, отдающие код ответа сервера 200 OK.

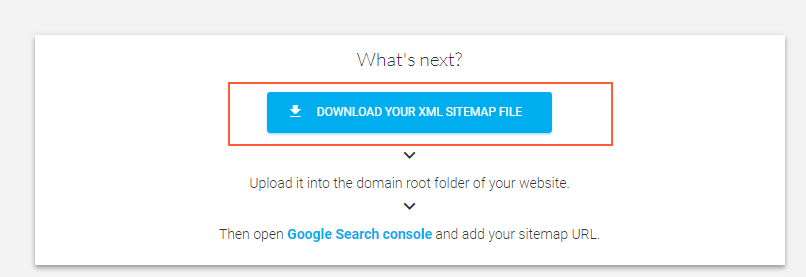

Если в карте сайта будет содержаться до 500 ссылок, воспользуйтесь бесплатной версией сервиса XML Sitemaps Generator. Алгоритм действий прост:

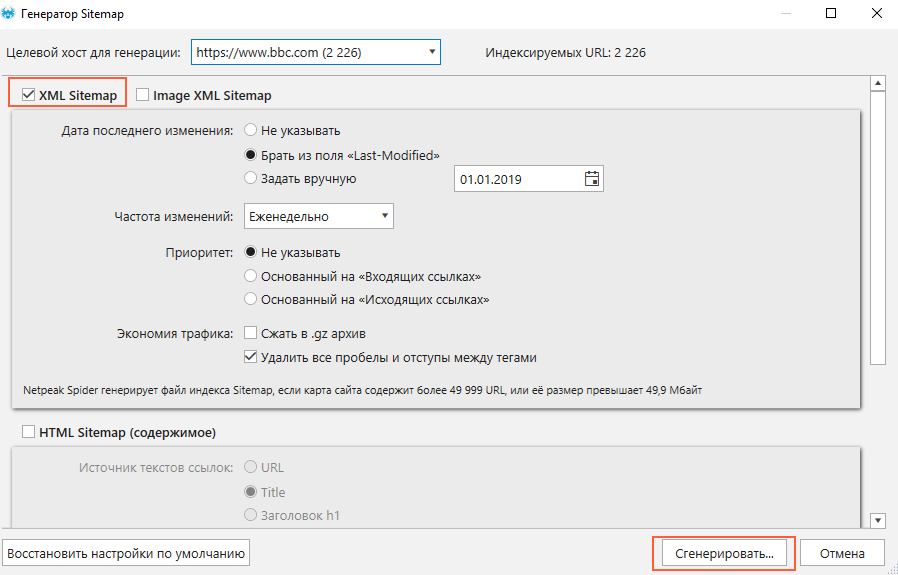

Для создания объемного файла Sitemap воспользуйтесь упомянутой выше программой Netpeak Spider. Для этого выполните следующие действия:

- Просканируйте весь сайт с настройками по умолчанию.

- В верхней части основного окна откройте меню «Инструменты» и выберите «Генератор Sitemap».

- Укажите необходимые параметры карты сайта, после чего нажмите кнопку «Сгенерировать».

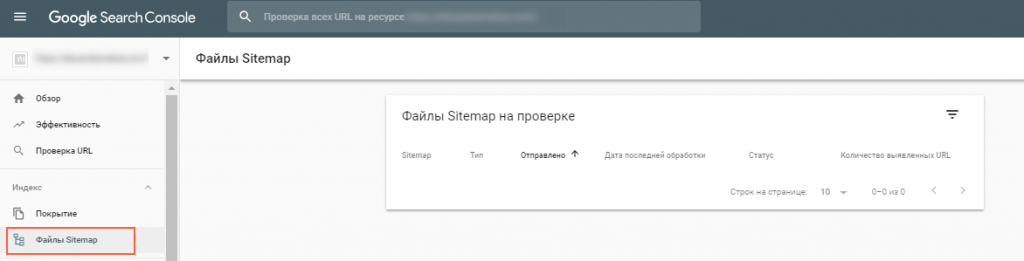

После этого сгенерированный файл Sitemap необходимо загрузить в корневую директорию сайта и предоставить доступ к нему поисковым роботам:

- Отправьте карту на проверку Google через панель для вебмастеров.

- В robots.txt впишите строку, указывающую местонахождение карты сайта: Sitemap: http://example.com/URL_sitemap.xml

- Отправьте ping поисковой системе Google: пропишите в браузере адрес http://www.google.com/ping?sitemap=, где после знака «=» будет указан адрес карты сайта.

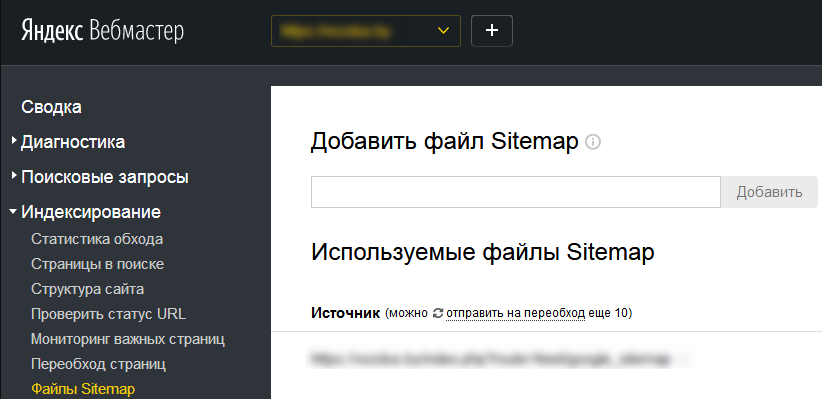

Проделайте аналогичные действия в инструменте «Яндекс.Вебмастере»

Недостаточно просто создать карту сайта — также необходимо следить за ее актуальностью и обновлять по мере наполнения сайта новыми страницами и документами. Многие CMS поддерживают автоматическое обновление карты сайта. Если его настроить невозможно, необходимо вносить изменения в файл вручную.

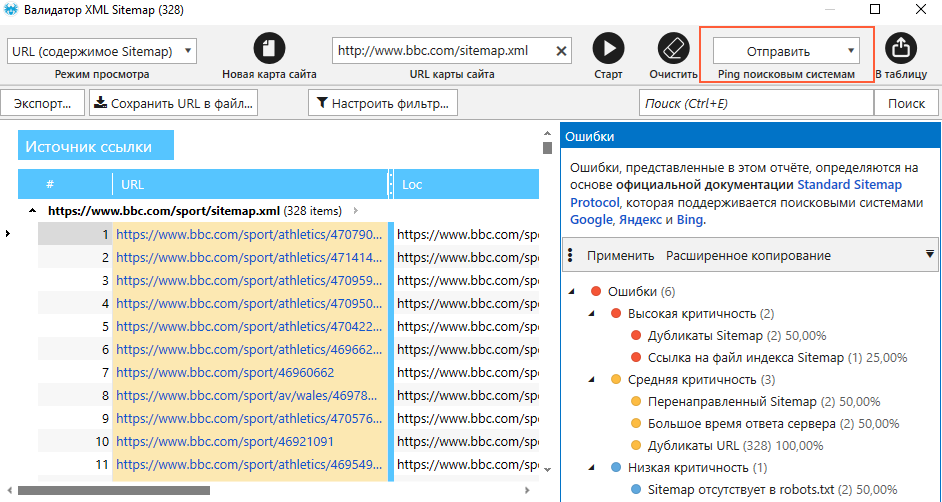

Каждый раз после обновления обязательно проверяйте файл на наличие ошибок, которые могут сказаться на скорости индексации и оптимизации сайта в целом. Выполнить процедуру проверки вы можете с помощью инструмента «Валидатор XML Sitemap» в Netpeak Spider. Чтобы им воспользоваться, вам необходимо:

- Перейти из основной панели программы в окно инструмента (меню «Инструменты» → «Валидатор XML Sitemap»).

- Ввести URL файла Sitemap и нажать «Старт».

- Ознакомиться с перечнем ошибок на боковой панели. В инструменте вы также можете отправить ping в поисковые системы, чтобы сообщить роботам об изменениях в файлах Sitemap.

3 Оптимизируйте скорость загрузки сайта

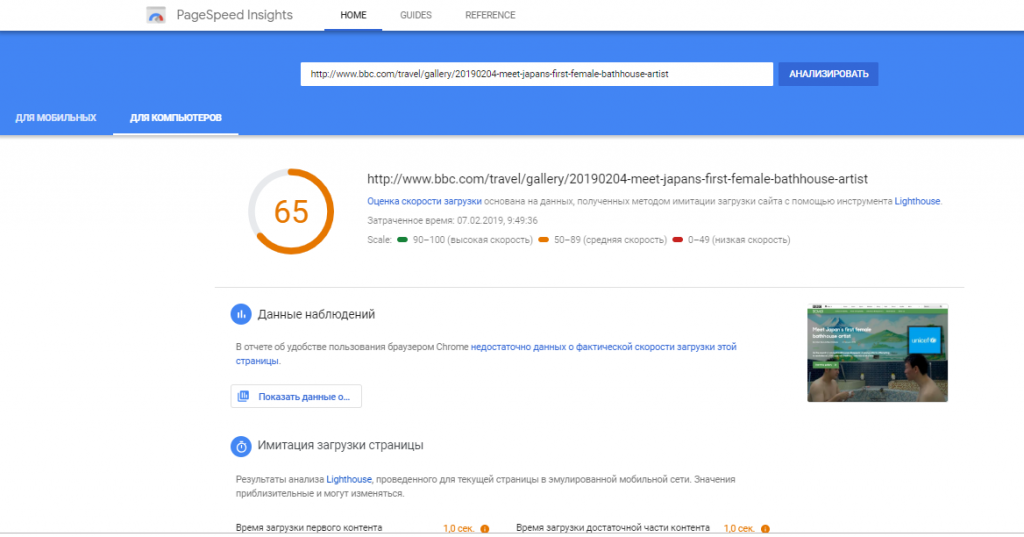

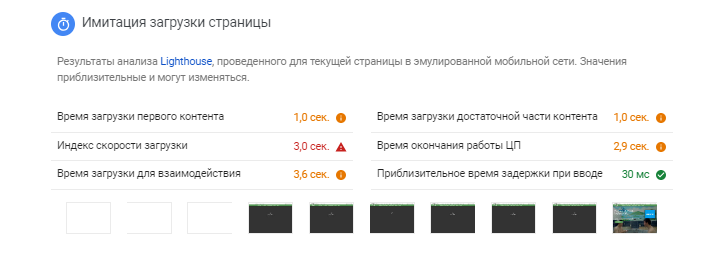

Чем быстрее будет работать сайт, тем проще поисковым роботам будет обойти его и внести максимум страниц в индекс. Чтобы узнать показатели скорости загрузки страниц вашего сайта, воспользуйтесь инструментом PageSpeed Insights.

Он оценивает быстродействие страницы по шкале от 1 до 100, основываясь на различных метриках.

Также инструмент дает рекомендации по ускорению работы страницы. Из всех основных и наиболее действенных методов улучшения скорости можно выделить следующие:

- Настройка серверного кэширования. Часть данных будет храниться на стороне сервера, что позволит не загружать их каждый раз, и тем самым уменьшить нагрузку.

- Использование сжатия в формате gzip. Так передаваемая информация будет храниться в сжатом виде на сервере, а затем распаковываться непосредственно в браузере пользователя.

- Сжатие изображений, за счет которого вес картинок уменьшается без потери качества. Существует множество онлайн-сервисов для сжатия, среди которых Image Compressor, TinyPNG, JPEGmini.

- Минификация кода CSS и JavaScript. Позволяет «очистить» код от лишних символов и пробелов, таким образом облегчая его. Для минификации можно использовать специальные сервисы, например, CSS Compressor и Javascript Minifier.

Дополнительно по теме

4 Регулярно обновляйте контент

Регулярно обновляющиеся сайты роботы сканируют чаще. Таким образом, создавая новые страницы или обновляя старые, вы косвенно влияете на улучшение индексации сайта. Увы, этот принцип работает и в обратную сторону — чем реже вы обновляете контент, тем меньше роботы посещают ваш сайт.

При этом важно помнить, что новый контент нужно делать уникальным. Иначе ваш сайт рискует остаться без внимания поисковых систем, либо же вовсе попасть под фильтр.

5 Не забывайте о внутренних ссылках на сайте

Внутренние ссылки облегчают роботам путь на страницы с высоким уровнем вложенности (больше 3-4 кликов от главной страницы), упрощая и ускоряя процесс индексации.

Но мало поставить внутренние ссылки на страницы с контентом. Важно, чтобы они соответствовали следующим требованиям:

- внутренние ссылки должны быть релевантными, то есть вести на страницы с полезным контентом, который дополняет содержимое текущей страницы;

- каждой ссылке в тексте должен быть присвоен релевантный анкор;

- на одной странице не должно содержаться слишком много внутренних ссылок. Точное количество назвать нельзя, но зачастую все зависит от размера контента: чем он объемнее, тем больше ссылок можно поставить;

- на любую страницу сайта должна вести внутренняя ссылка.

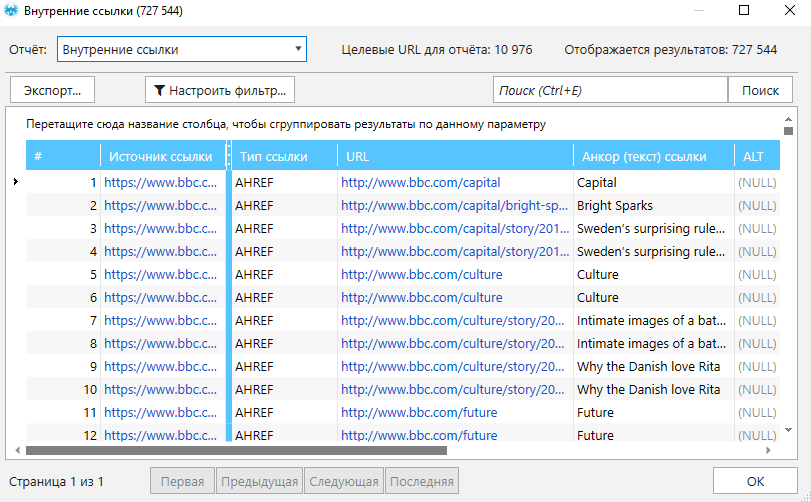

Проверку внутренней перелинковки на сайте вы можете провести в Netpeak Spider:

- Просканируйте сайт.

- Откройте меню «База данных» и выберите отчет под названием «Внутренние ссылки». В открывшемся окне вы сможете ознакомиться с начальными и конечными URL, а также просмотреть анкоры.

На боковой панели программы проверьте, не обнаружил ли краулер на сайте ошибки «PageRank: отсутствуют связи» и «PageRank: отсутствуют исходящие ссылки». На страницы с этими ошибками необходимо обратить особое внимание, так как они нарушают правильность внутренней перелинковки.

6 Нарабатывайте обратные ссылки

Важность обратных ссылок сложно переоценить: они повышают доверие к сайту со стороны поисковых систем и являются одним из главных факторов ранжирования. Помимо всего прочего, они также способствуют ускорению индексации.

В данном случае самое главное — сократить время между созданием новых страниц и получением на них ссылок из внешних источников. Вот самые быстрые и простые способы получить обратные ссылки на новые страницы сайта:

- разместить ссылку на сайтах-агрегаторах;

- поделиться ссылкой в социальных сетях;

- разместить ссылку на форумах и сервисах вопросов и ответов;

- вставить ссылку в отзывах на специализированных порталах;

- в случае с инфографикой ею можно поделиться в специальных каталогах, поставив ссылку на источник.

Подводим итоги

Быстрая индексация сайта способствует успешному поисковому продвижению, поэтому в интересах каждого владельца сайта работать над ее ускорением. Добиться наилучшего результата вы сможете, следуя таким рекомендациям:

- следите за правильностью инструкций в файле robots.txt;

- создайте, своевременно обновляйте и систематически проверяйте XML Sitemap;

- оптимизируйте скорость загрузки сайта;

- регулярно обновляйте контент;

- не забывайте о внутренних ссылках на сайте;

- нарабатывайте обратные ссылки.